HotpotQA分析

数据说明

HOTPOTQA: A Dataset for Diverse, Explainable

Multi-hop Question Answering

简单数据分析

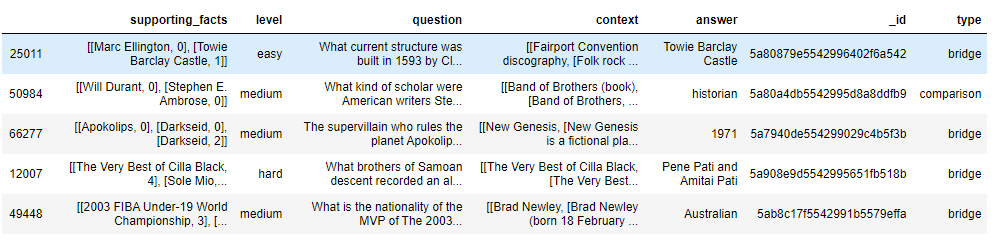

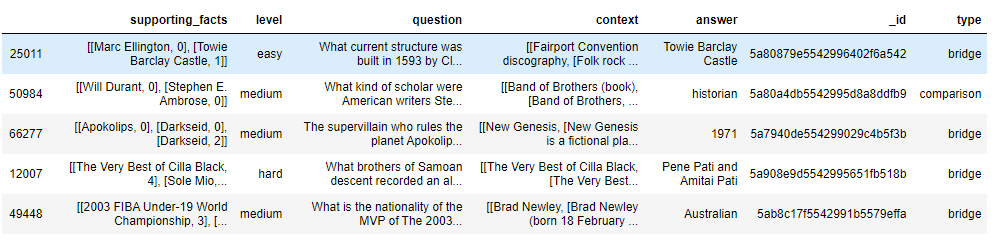

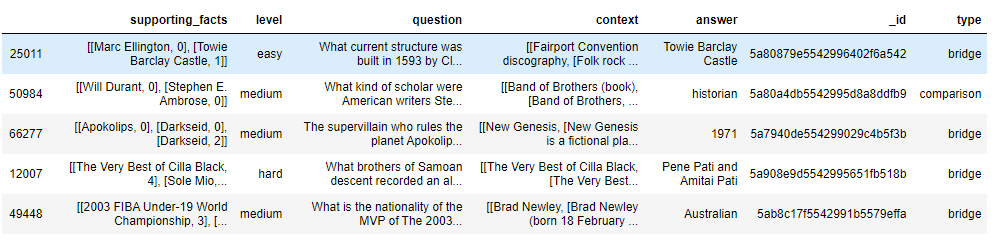

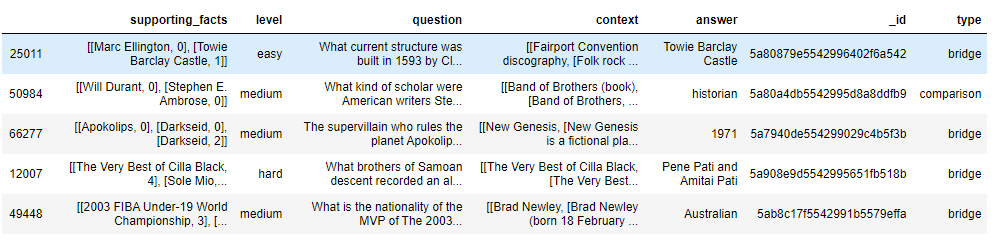

数据样例

答案长度分布

HOTPOTQA: A Dataset for Diverse, Explainable

Multi-hop Question Answering

SAE:Rank+(预训练+GNN联合训练)

SAE:Rank+(预训练+GNN联合训练)

Attention详细解析

Attention详细解析